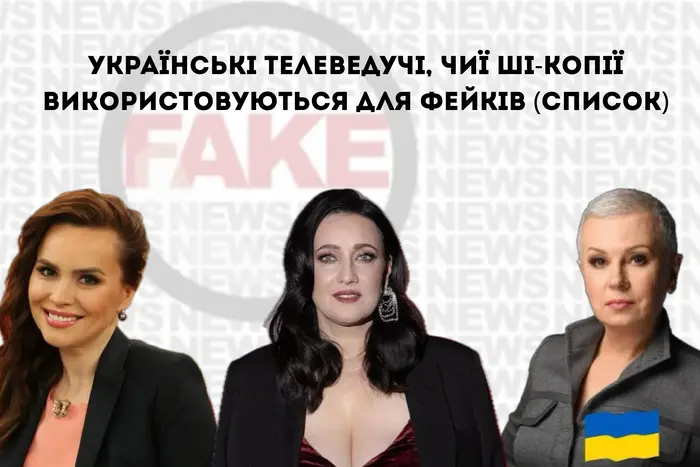

Українські телеведучі, чиї ШІ-копії використовуються для фейків (список)

Українські журналістки дедалі частіше стають жертвами цифрових маніпуляцій у TikTok: їхні голоси та образи використовують для створення фейкових відео за допомогою штучного інтелекту. Про це повідомляє «Главком» з посиланням на розслідування Texty.org.ua.

Різниця настроїв у різних соцмережах пояснюється тим, що ними користуються люди різного віку. Наприклад, у Facebook переважають старші користувачі, тож у них свої погляди, упередження та реакції – часто більш консервативні й критичні. Натомість молодь, яка активніше сидить у Threads, ставиться до ШІ спокійніше й більш прихильно. Тому й виходить, що пенсіонерам він здебільшого не подобається, а молоді – навпаки.

Із 1 серпня по 30 вересня 2025 року дослідники шукали відео в TikTok із присутністю жінок-журналісток, використовуючи техніку «снігової кулі».

Було проаналізовано 595 відео, де використовувався образ відомих жінок, і виявлено, що ці ролики набрали понад 24 млн переглядів. Деякі відео привернули особливу увагу через синтетичну міміку, інтонацію та неправдиві повідомлення.

Прикладом став образ телеведучої Соломії Вітвіцької («1+1»), який активно використовують у TikTok. Дослідники виявили 100 відео, де її голос і рухи повністю або частково згенеровані ШІ.

«Та для нас стало несподіванкою, що образ телеведучої активно використовують у ТікТоці й далеко не завжди з добрими намірами. Ми виявили 100 відео, у яких віртуальна Вітвіцька говорить і діє завдяки алгоритмам штучного інтелекту. У деяких роликах її голос згенеровано, в інших створено повністю фейкові сюжети із синтетичною мімікою, інтонацією та неправдивими повідомленнями», – йдеться у повідомлені.

Українські журналістки дедалі частіше стають «цифровими аватарами» – не з власної волі, а через бажання маніпуляторів використати довіру до них як інструмент впливу.

«Те, що ще кілька років тому здавалося технологічною цікавинкою, сьогодні перетворюється на форму онлайн-насильства. А штучний інтелект став знаряддям дискредитації та дезінформації», – йдеться у повідомленні.

«Ми вирішили розібратися, як у ТікТоці використовують штучний інтелект для створення чи спотворення відео з образами журналістів. Наш фокус – журналістки, які у відсотковому виразі становлять більшість у медіагалузі України», – зазначили дослідники.

У процесі аналізу було виявлено десятки роликів зі зміненим голосом, зовнішністю або стилем мовлення. «У роликах використовуються різні технології штучного інтелекту – від синтезу голосу і накладання його на реальне зображення до повноцінних дипфейків зі згенерованими і зображенням, і звуком», – додали дослідники.

Більшість контенту містить ознаки аудіовтручання. «Інакше кажучи, реальні новинні сюжети були озвучені новими голосами, створеними для просування певного меседжу, сюжету чи наративу. Подеколи голос штучно моделювався під відомих українських телеведучих, і це посилювало ефект достовірності. Такі аудіоманіпуляції часто видають самі себе. Неприродна вимова, неправильні наголоси, дивні паузи і рваний ритм мови – усе це ознаки машинної генерації», – йдеться у повідомленні.

Дослідники промаркували 328 тікток-відео з аудіоманіпуляціями і ще 267 відео, де штучний інтелект використовувався для створення чи зміни і зображення, і голосу.

Список українських телеведучих, чиї образи найчастіше використовують у фейкових відео на TikTok:

- Соломія Вітвіцька з «1+1» (17 відеогенерацій і 83 аудіоманіпуляції);

- Анастасія Даугуле з телеканалу «Інтер» (26 відеогенерацій і 42 аудіоманіпуляції);

- Алла Мазур з «1+1» (13 відеогенерацій і 42 аудіоманіпуляції).

Нагадаємо, що штучний інтелект (ШІ) несподівано став головним претендентом на престижне звання «Людина року» за версією американського журналу Time. За даними букмекерського агентства Polymarket, шанси ШІ на перемогу оцінюються у 37%, що значно перевищує показники його найближчих конкурентів.